人工大脑之父雨果访谈

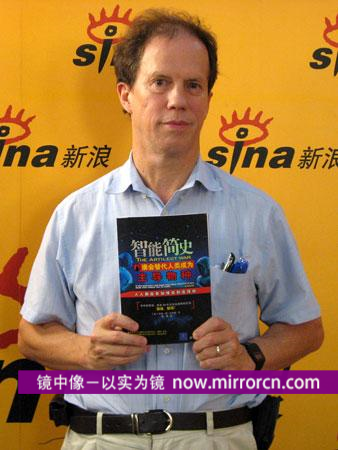

世界人工大脑之父雨果·德·加里斯教授(右)及其夫人雷国庆女士(左)做客新浪网

新浪科技讯 北京时间6月21日下午15时-15时45分,世界人工大脑之父雨果教授做客新浪网,就人工智能及机器人的发展趋势、人工智能研究的利弊以及未来机器人是否会替代或威胁人类等有关问题与网友进行在线交流。

以下为文字实录:

主持人:刘允:各位网友大家下午好!欢迎来到新浪嘉宾聊天室。今天我们非常荣幸地请到了世界人工大脑之父雨果·德·加里斯教授,就人工智能及机器人的发展趋势,以及未来机器人是否会替代或威胁人类的有关问题与网友进行在线交流,欢迎广大网友踊跃提问。

今天我们还请到了雨果·德·加里斯教授的夫人雷国庆女士,雷国庆女士将为我们担当一部分的翻译工作。

各位网友,除了通过电脑访问新浪网,您还可以通过手机访问新浪网在移动中关注聊天全程,手机新浪网的网址是sina.cn。

主持人::我觉得非常巧合,去年6月份史蒂芬·霍金先生也是这时候来到北京,而雨果教授也是被誉为人工智能领域的霍金,我想先请雨果先生简单谈一下您所从事的研究领域。

雨果:我的中文普通话不好(笑)

雨果(翻译):他说他的工作主要是做人工大脑,做人工大脑的过程现在发展得很快,现在做这个工作只需要两千美金,就可以有一个生产大脑这样一个设备,我们说是一个板子,不太大的一个东西。

主持人::非常感谢雨果教授。我想请问一下现在世界上的人工智能已经达到了一个怎样的水平?有没有什么具体的例子?

雨果(翻译):他说现在人工大脑的发展不能说到了一个什么水平,因为它现在一直在飞跃地往前发展,而且可能是20年、30年后人工智能机器,就可以和人做朋友了,大家可以想像这是一个什么程度,这是一个发展非常快的时机。

主持人::比尔·盖茨先生在今年年初的时候,在《科学美国人》杂志上做了一个预言,他说机器人也将经历一个类似于PC的发展历程,在不久的将来可能实现未来家家户户都有机器人,您怎么看待这么一个机器人的发展趋势?未来又可能出现怎样的智能机器?

雨果(翻译):我觉得这个是非常有可能的事,而且经过大约10到15年,肯定就会发展成世界最大的一个产业,这只是个时间的问题。

主持人::雨果先生刚才说大概10到20年盖茨的预言就有可能实现?

翻译:对。

主持人::其实我们知道在美国广播公司最近的一部新影片中《地球最后的岁月》,在电影中是将您的智能机器与霍金的黑洞等并称为“人类所面临的七大威胁”。而您所预测的智能机器将在未来50年左右发生,很多网友包括我在内也非常关心这么一个问题,就是这种情况是否真的可能发生?它会这么早就到来吗?

雨果(翻译):确实去年10月份在美国ABC曾经放过关于这样的两个纪录片,其中有一个就讲了七大威胁,能够灭绝人类的七大威胁,其中有一个就是智能机器。确实在50年之后可能会出现这种情况,就是人类的智能机器,他们的智能会得到飞速发展,他们力量的发展是成几何倍数的增长,可能是他们现在能力的上亿倍,上十亿倍,那时候他们对待这个能量可能就像拍死一个蚊子这么简单,所以这确实也算是21世纪一个政治性的问题。

雨果教授比划现在人工智能的智力与人类智力的差距

主持人::非常感谢雨果教授。其实我在想一个问题,因为任何事物它都是两方面的,有它消极的一面,也有积极的一面,那么您做出来的这个预测是不是过于悲观?它会不会导致人们过早的抵制您的研究,因为我们知道世界仅有的四个研究人类大脑的机器均源自您之手?

雨果(翻译):我认为这要从我们短期和长期来看,如果从近期来看的话,用一个非常短的时间来看的话,如果我们停止人工智能研究是一个非常愚蠢的行为,因为这是对我们人类非常好的事情,我们可以让智能机器给我们打扫房间,可以看小孩儿,可以说益处非常多。当然如果从长期来说,这确实可能是一个问题,因为目前来说可能这是人脑的智慧(很高),这是人工智能的智慧(很低),差别非常大的。但是长期来说随着人类技术的发展,人脑的智慧和智能机器的智慧这个差距可能会缩短,在缩短之前的这段距离我认为是非常安全的。但是长期来看,一旦它要超过人类智能的时候确实非常危险。其实我那本书可能就是从这方面来讲,从未来来看可能确实是一个非常危险的过程,也可以说我这么说是非常非常悲观的,但是这是一个长期的预测。

主持人::就是说我们在短期之内还是应该保持一个乐观的态度,对于机器人的发展。

网友:您曾预言50年后机器人将威胁人类,而阿西莫夫曾提出机器人的三大法则,实际上这三大法则就限制了人类对机器人构成威胁,这是不是与您的预言相左?或者说您对这三大法则能否作用于机器人表示怀疑呢?

雨果(翻译):我认为这还是分成两方面来看,这也不能一概而论,还是从短期来看,当他们和我们相比还没有足够的智慧的时候,我们当然可以对他们进行指手画脚,可以说你要做什么,你要做什么,这时候是不对我们构成任何威胁的,不对人类构成任何威胁。但是另一方面从长期来看,万一有一天他们的智慧超过了人类,这时候你再对他们说,我这个地方输错了,我再给你改一下,或者说我们成为朋友吧,这时候他们根本不会把人类放在眼里,会把我们看成蚊子一样随时拍死,可能是这种状况。

主持人::假如这种情况有一天发生了,那么我们是不是可以通过为机器人设计一个毁灭开关,来防止这种情况的发生?我相信这是很多人都可能想到的一个问题。

雨果(翻译):我觉得这个都是不太可能的,可以分两点,第一点,假设我们现在把我们自己当成这样一个智能机器人,这时候我们就会比人类聪明,这时候你允许人类往你身上装这个东西吗?假设我们还是智能机器人的话,我们会觉得相当难看,为什么身上都是这种按钮,而且这些按钮可以决定我们的生死,所以这个可能是很难实现的,到那个时候也许智能机器人的意识也不允许装这样一个装置在他的身上。

第二点,到那个时候智能机器人会非常普遍,他们可能会在电力、供水各方面为我们人类进行各种各样的工作,这个时候即使他们发狂或者出现什么状况,如果我们想尽各种方法安上毁灭开关的话,这时候他们毁灭了,但是你可以发现没有电了,没有水了,其实对我们人类本身也会产生非常具有毁灭性的影响。所以从这两点来看都是不太可能的。

主持人::看得出来到以后机器人会非常聪明,能够有一个自我的保护意识。

雨果(翻译):刚才那是非常好的问题,在我的那本书中,叫《智能简史》中也有更多对这个答案的详细叙述,大家可以在这本书中找到其他更多的例子和具体的回答。

主持人::大家如果想进一步了解雨果先生,也可以通过这本书来了解。继续我们的话题,接着回答一位网友的提问。

网友:请问雨果先生,我看过电影《黑客帝国》,您觉得机器人会取代人类吗?我现在想起来觉得非常恐怖,就像原子弹的发明一样,对人类是福音还是灾难?人类有办法来控制这个灾难的发生吗?

雨果(翻译):我觉得这个问题统治了我的一生,我一直在考虑这个问题,我觉得这个问题也可能甚至说影响整个世界,这是一个很好的问题。我们在科幻电影中就看到智能的机器人,我们看了以后就感觉好遥远,会想这是科幻电影。但是有可能这样一个看似遥远的事情,可能会很快成为现实。

但是对这个问题也是有两派人的观点非常不一样,一个是赞成派,一个是反对派,赞成派还是希望发展这样一个智能机器人,觉得这样的智能机器人有太多太多的优点,他们不会像人类一样会死去,他们可以随便到自己想去的地方,这是非常美妙的事情,人类做不到的事情,他们可以做到。当然另一方面,确实正如刚才那位网友担心的,确实可能会引起各种各样的问题,所以说就像刚才我介绍的那本书一样,我那本书就是从这方面出发的,可能这是一个非常非常悲观的预见,所以说我认为在21世纪末,如果说有世界大战的话,那个时候能够伤害人类的就不一定是军事能力,很有可能是一种生物技术、生物武器,所以说这也是一个潜在的危险。

雨果教授:当人工智能超过人类智慧该怎么办

主持人::看来这个危险还是有可能发生的。其实我们还可以注意到最近有一个比较有意思的新闻,就是今年上半年韩国信息通信部预测,2015年至2020年间,每个韩国家庭将拥有一部机器人,而韩国政府则表示将起草世界上第一份机器人的《道德宪章》,以防止人类与机器人之间的虐待和伤害,尤其是要保护机器人的权利。既然未来的机器人可能会给人类带来潜在的威胁,您觉得我们有没有必要去保护机器人的权利呢?

雨果(翻译):首先稍微纠正一下,我做的这个不是叫机器人,机器人其实就是一堆钢铁,但是我讲的是一种人工智能,就像我们大脑的这样的东西。所以说未来这样一个人工智能,这样的机器可能会超越我们的智慧,大概上百万的超过我们的智慧,而且这也不是一个很遥远的梦,可能会在一瞬间,在20年之内就会来到我们面前。

但是有一个问题,我们现在讲如何保障机器人的权利问题,但是这个还只是在机器人的智能低于我们时候的这样一个话题,但一旦智能机器人超过了我们智慧的话,那时候问题是这样吗?到底谁给谁保护的权利?那时候我们应该考虑我们怎么从机器人那里获得权利,这时候我们和机器人的位置就完全颠倒了,这也是一个政治问题,也是一个宗教伦理问题,我们人类要不要选择制造这样一个超级智慧的智能机器人?我们(人类)是不是甘心做第二位?我们(人类)一直是第一位,但是我们是不是要下定决心让出第一位,让给智能机器人。

主持人::刚才我们聊了很长时间关于雨果先生的一些预言,感觉很沉重,当然我们也不希望这种灾难发生和到来。接下来我们请雨果教授来聊一聊技术上的问题,并回答一些网友的提问。我们知道您开创了可进化硬件的研究领域,是进化硬件和进

化工程学的奠基人,我想替网友问一个问题,现在已经有可以进化的智能机器了吗?

雨果(翻译):首先这是一个非常热门的研究话题,美国、欧洲以及日本这些国家的学者都在研究相关的问题,这样一个技术最早想到能进行这个技术应用的实际是日本,日本做得是比较好的,他们把各种芯片植入到一些机器里面去,试图进行这样一个应用。

另一方面,这样一个可进化硬件从我们将来来看,它是一个非常有实际作用的成果,它就像一个细胞分裂这样,因为它完全就像一个胚胎制造,我们有个专业属于叫胚胎制造,就是属于细胞分裂,由一个细胞分裂为两个,两个分裂为四个,这样一个过程,然后他们不停地分裂,体积增大,就像人一样,人慢慢成长为胎儿,然后成形成人,是这样一个过程。这样来看,我们要想造这样一个非常具有智能化,非常复杂的人工大脑的话,第一个就是需要一个胚胎制造的技术,再一个就是要一个可进化硬件,这两个都是必要的。

网友:请问雨果教授,这种智能机器的进化是硬件上的进化还是软件上的进化?

雨果(翻译):简单说都有可能的,我们既可能从硬件上进行进化的设计,也可能进行软件上的设置,都有可能的。作为个人,我主要是从硬件方面考虑进行这样一个研究的。

网友:请问您研制出来的智能机器有没有可能自发产生类似于人类繁殖的欲望?想自己制造成一个机器人宝宝,并把宝宝称作为“儿子”或者“儿女”。

雨果(翻译):按我们在生物界来说,一切生物都是必须要繁殖繁衍后代的,如果不这样的话就会灭亡。但是这样一个智能机器我们从长远来看,他也确实可能有这种想法,当然这个也不是一概而论,比如他们想进行宇宙开发这样的事情,希望有很多的儿女,这时候可能他们就选择繁殖,有很多后代。刚才也多次提到当真正的智能机器人超过我们智慧的时候,这时候我们就无法控制他们,你不知道他们想要什么,因为他们太聪明了,有可能他们是我们的主人了,所以我们就无法知道他们具体想什么了。

雨果教授和他的《智能简史》

网友:人工智能是否可以产生感情、善良等文明性的思维?

雨果(翻译):我觉得这个也是可能的,但是这个也是涉及到哲学伦理方面的问题,因为我不是哲学家,我坐在这儿的目的就是劝那些哲学家们能够认识到这个问题,就是我们认识到这样一个庞大的问题,我现在的理论是处在一个起步的阶段,我推广这个理论也花了好几年,一直在推广这个新的理论,具体来说我对哲学方面的东西,比如针对人类思维真的不是很了解,我们现在考虑的问题都是站在我们人类的基础上进行考虑,按照人类的哲学伦理来考虑,但是一旦他们有了自己的智慧之后,超过人类智慧之后,他们会形成一个怎样的思考方式,形成一个怎样的思维,这是我们无法预知的。因为如果有这样一天的话他们就远远超过我们了,我们就无法知道他们考虑什么了,所以我们是不是要冒险制造这样一个人工智能。

主持人::由于我们今天时间的关系,我们的聊天马上就要结束了,最后我们非常欢迎雨果先生来到北京、来到新浪网,我想再请雨果教授最后对网友谈一谈关于人工智能我们应该有一个怎样的认识?

雨果(翻译):雨果先生还是对刚才我们如何看待人工智能的问题一再强调,现在人的智慧还是远远超过智能机器人的智慧,智能还是处于相对低的水平,人类拼命想让他们发展,不停提高他们的智慧水平,这时候我们会增加很多劳力,创造很多的经济效益,这是非常非常好的。

但是当我们把这种智能机器人的智慧发展到一定程度的时候,接近我们智慧的时候,这时候我们就在人类中出现了分化,有些人认为这时候我们应该停止了,要不然再发展的话他们就会超过我们,就会引起灾难;而另外一些人他们认为发展得越来越好,以至于大大超过我们也是没有关系的,所以有可能形成这样两派人的争论,而且很有可能因为这样意见的分歧爆发战争,所以这是一个非常悲观的预测,可能会爆发战争,而且可能会持续十几年、二十年左右的这样一个时间,就像当初美国南美战争是差不多的。

最后再解释一下,为什么我现在来到北京做关于这方面的研究和宣传,主要是因为我觉得21世纪中国是非常有希望的,我觉得21世纪是中国的世纪,所以我希望能够把这样一个非常前沿性的话题带到中国来,让大家也能了解一下。

主持人::感谢雨果教授,由于今天时间的关系我们的聊天就到此结束了,大家如果对于雨果教授还想进行深入了解的话,也可以看雨果教授的新书《智能简史》,今天的聊天到此结束,再次感谢雨果教授!

雨果:非常感谢!

雷国庆:谢谢!

(本次访谈结束)

PS:人工大脑之父雨果:人工智能未来或取代人类

上一篇: 谷歌的终极目标是“人工智能”?